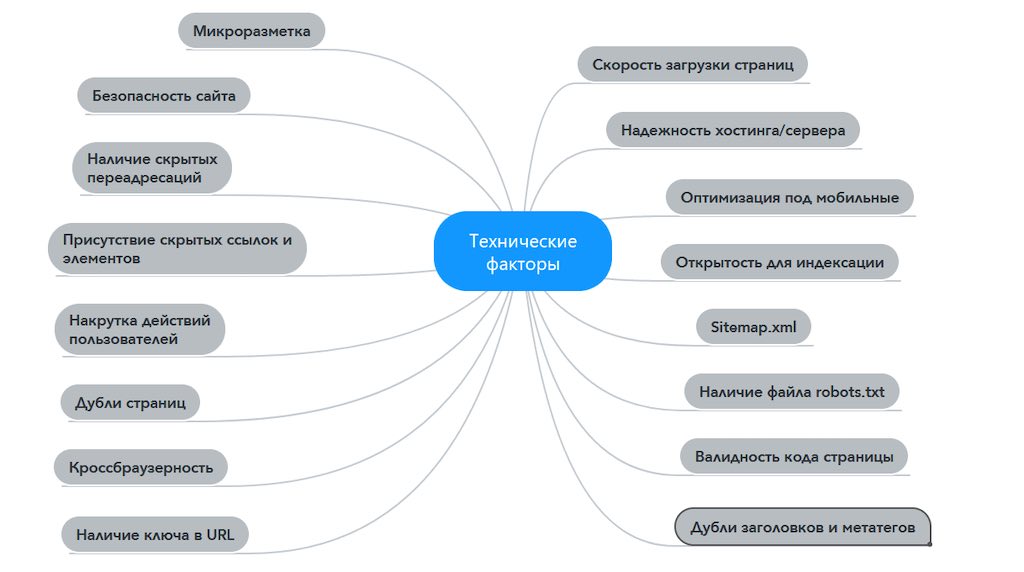

Технические факторы ранжирования — это факторы, которые влияют на позиционирование страниц в поисковой выдаче. Они включают в себя множество технических параметров и метрик, которые алгоритмы поисковых систем используют для определения качества и релевантности контента на странице.

Технические факторы ранжирования Яндекс

Нужно понимать, что технические факторы ранжирования — это зона ответственности WEB разработчика, который вам создавал сайт. Как правило, все проблемы со слабыми позициями и невозможностью вывести сайт на первую страницу связаны с технической стороной.

Опытный SEO оптимизатор должен выявить все проблемы технического характера перед началом работ по продвижению сайта. Важно знать — «кривые сайты» сегодня не продвигаются.

Из моей 17-летней практики очень часто случалось так, что после перечисления недоработок по сайту их либо уже некому было устранять, либо программист не мог справиться с теми требованиями, которые я указывал в техзадании на доработку. В итоге — приходилось переделывать все самому.

Теперь предлагаю рассмотреть все основные технические параметры, которые Яндекс учитывает при ранжировании.

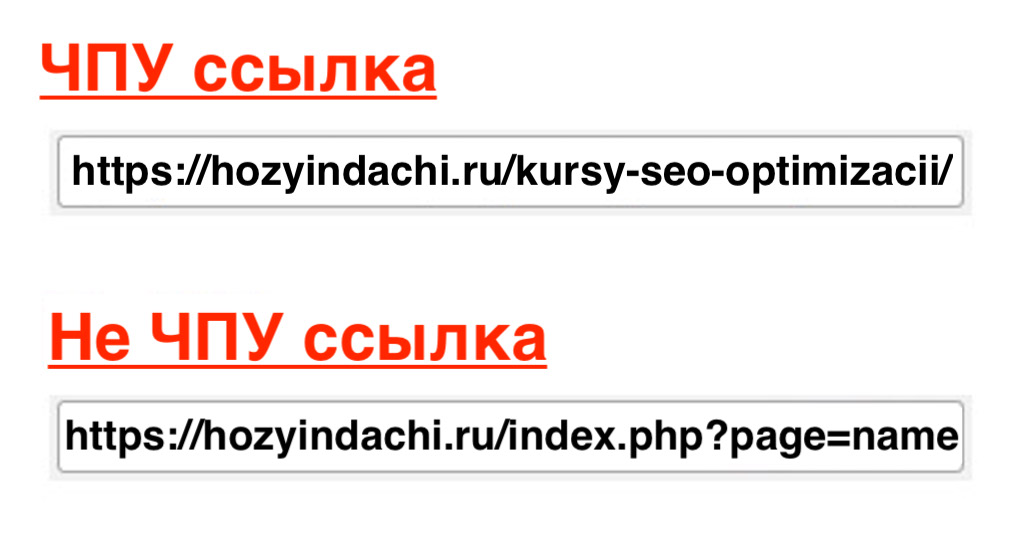

ЧПУ — человеко-понятные URL

ЧПУ — это адрес страницы сайта (URL) преобразованный из кирилических символов в удобочитаемый для пользователя вариант. Пример 👇👇👇

Помимо удобств для пользователей человеко-понятные URL упрощают индексацию сайта поисковыми роботами. В таких ЧПУ четко указывается вложенность адреса страницы относительно корневой папки и отображается вся структура сайта.

При изменении ЧПУ на сайте необходимо перенастроить 301 редиректы. Кроме этого, нужно перепрописать все ссылки ведущие на эти страницы. Причем уже без использования 301 редиректа, чтобы большое количество переадресаций не повлияло в худшую сторону на позиции всего сайта.

В момент перехода на новые URL адреса сервер должен отдавать содержимое страниц без каких-либо перенаправлений.

Дубли страниц на сайте

Дублирование страниц возникает при смене URL адреса или при создании новых страниц на сайте. При этом дубли страниц могут появляться автоматически. Чем крупнее сайт, тем больше может быть дублей.

Чаще всего такие проблемы возникают у интернет-магазинов, когда один и тот же товар находится в разных категориях. Например товарная карточка «плинтус Cosca» может находиться как в разделе напольных плинтусов, так и на странице акций и распродаж.

Для поисковых роботов такого плана страницы являются дублями, на индексацию которых затрачивается дополнительный краулинговый бюджет. Это очень негативно сказывается на ранжировании.

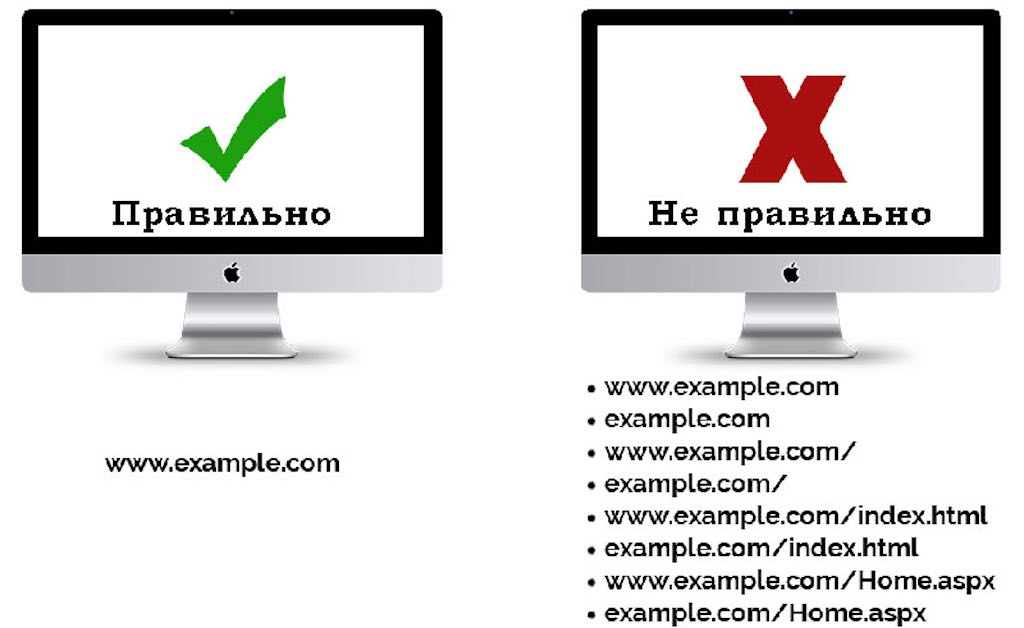

Основные виды дублей страниц на сайте

Дубли со слэшем в конце URL адреса — https://www.primer.ru/page1/

Дубли без слэша в конце URL адреса — https://www.primer.ru/page1

С окончанием index.html — https://www.primer.ru/page1/index.html

С окончанием index.php — https://www.primer.ru/page1/index.php

С протоколом http — http://www.primer.ru/

С протоколом https — https://www.primer.ru/

C www — https://www.primer.ru/page1/

Без www — https://.primer.ru/page1/

Это самые распространенные виды образования дублированных страниц. Для улучшения ранжирования необходимо избавиться от всех дублей, приведя их к одному общему виду.

Устранить дубли страниц можно двумя способами. Первый — прописать через тэг canonical канонические адреса страниц. Второй — настроить универсальный адрес для всех карточек товаров, который будет формироваться автоматически. Это поможет избавиться не только от дублей, но и от большого уровня вложенности.

Зеркало сайта

Зеркало сайта — это полная копия основного сайта или блога, но размещенная в сети под другим доменным именем (читать подробнее). В первую очередь их создают для того, чтобы распределять нагрузку на основное зеркало (главный сайт).

Зеркала сайта несут в себе отрицательное влияние на ранжирование. Вот самые основные причины их возникновения:

Доменные зеркала — тот случай, когда несколько доменных имен привязываются к одному физическому URL.

Служебные доменные имена — сгенерированные в автоматическом режиме самим хостингом.

IP-адреса сайта — (в качестве примера, когда сайт доступен по ip-адресу 192.168.1.1).

Обнаружить зеркало сайта можно просто. Сначала через сервис 2ip.ru определить ip-адрес своего сайта, а затем ввести его в строку браузера.

Перекрываются зеркала с помощью 301 редиректа или запретом индексации через файл robots.txt.

Файл Robots.txt

Robots.txt — неотъемлемый компонент корневой папки сайта, который считается дополнением для стандарта Sitemaps. В целях реализации выбранной стратегии продвижения сайта необходимо внимательно изучить нюансы использования этого стандарта.

Данный файл указывает поисковым роботам скроллерам, какие файлы на сайте нужно индексировать, а какие запрещены к индексации. В файле присутствуют две основные директивы:

Disallow — Указывают на папки сайта или каталоги запрещенные для индексации.

Allow — директива, отдающая команду роботам индексировать файлы.

Пример файла robots.txt для моего сайта:

User-agent: * Disallow: /testovaya-glavnaya/ Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Disallow: /tag/ Disallow: /readme.html Disallow: *?replytocom Allow: /wp-content Allow: */uploads Allow: /*.css Allow: /*.js User-agent: GoogleBot Disallow: /testovaya-glavnaya/ Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Disallow: /tag/ Disallow: /readme.html Disallow: *?replytocom Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php User-agent: Yandex Disallow: /testovaya-glavnaya/ Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: /tag/ Disallow: /readme.html Disallow: *?replytocom Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php Clean-Param: utm_source&utm_medium&utm_campaign Clean-Param: openstat Sitemap: https://hozyindachi.ru/sitemap_index.xml

Коды ответа сервера

Для того, чтобы пользователь увидел определенную информацию в своем браузере поисковая система сначала отправляет запрос на сервер, где находиться сайт и только при получении от него команды 200 Ок понимает, что со страницей все нормально и представляет её в поиске. Кроме команды 200 Ок существуют и другие коды ответов.

301 и 302 редиректы

Как правило 301 и 302 редиректы используются для переадресации страниц сайта на другие URL и информирования поисковой системы о удалении страниц, с которых идет перенаправление.

Большое количество редиректов оказывает повышенную нагрузку на роботов и не рекомендуется к использованию. Рекомендую ознакомиться — как 301 редирект убивает SEO продвижение сайта.

304 код страницы

Код страницы 304 — сообщает поисковому роботу о последних изменениях производимых на страницах сайта. Работает это так.

Серверу отдается заголовок If-Modifited-Since и если изменения на страницах не обнаруживаются, то от сервера для роботов возвращается команда 304 Not Modified. При этом страница не загружается и не индексируется.

Как следствие — снижается нагрузка на сервер, ускоряется загрузка страниц сайта, в результатах поиска отображается дата последних обновлений страницы, ускоряется индексация страниц, улучшается ранжирование.

Код ответа страницы 404

Тот случай когда поисковик обращается к серверу и попадает на несуществующую или удаленную страницу. Тогда сервер отдаёт код 404.

Простой пример — вы набираете в поисковой строке Яндекс запрос «как испечь вкусный торт». Вам выдаются WEB сайты с информацией релевантной вашему запросу, но при переходе на один из этих ресурсов вы видите на экране своего компьютера вместо рецепта изготовления торта, ошибку 404.

Такие 404 ошибки увеличивают показатели отказа на сайте и негативно влияют на его позиции, ухудшая при этом поведенческие факторы. Эти ошибки нужно своевременно выявлять и устранять.

Карта сайта Sitemap

Sitemap.xml — это файл на сайте, который сообщает поисковым роботам о доступных для индексации страницах. В этот файл входит список значимых URL адресов сайта в сочетании с метаданными.

После создания и загрузки файла Sitemap.xml на сайт рекомендуется выполнить его проверку на валидность с помощью инструмента в Google Search Console или Вебмастер Яндекс.

Битые ссылки

Битые ссылки очень негативно воспринимаются как поисковыми системами, так и живыми людьми. Очень сильно раздражает переход по битой ссылке, после которого пользователи просто покидают сайт. Следом растут отказы пользователей в метрике и ухудшаются позиции сайта.

Задача SEO оптимизатора своевременно выявить битые ссылки, удалить их или перенаправить на рабочие URL адреса. Как правило, в популярных CMS за эту функцию отвечают специальные плагины. Они либо информируют своих владельцев о наличии битых ссылок, либо выполняют автоматическое перенаправление по заранее подготовленному алгоритму.

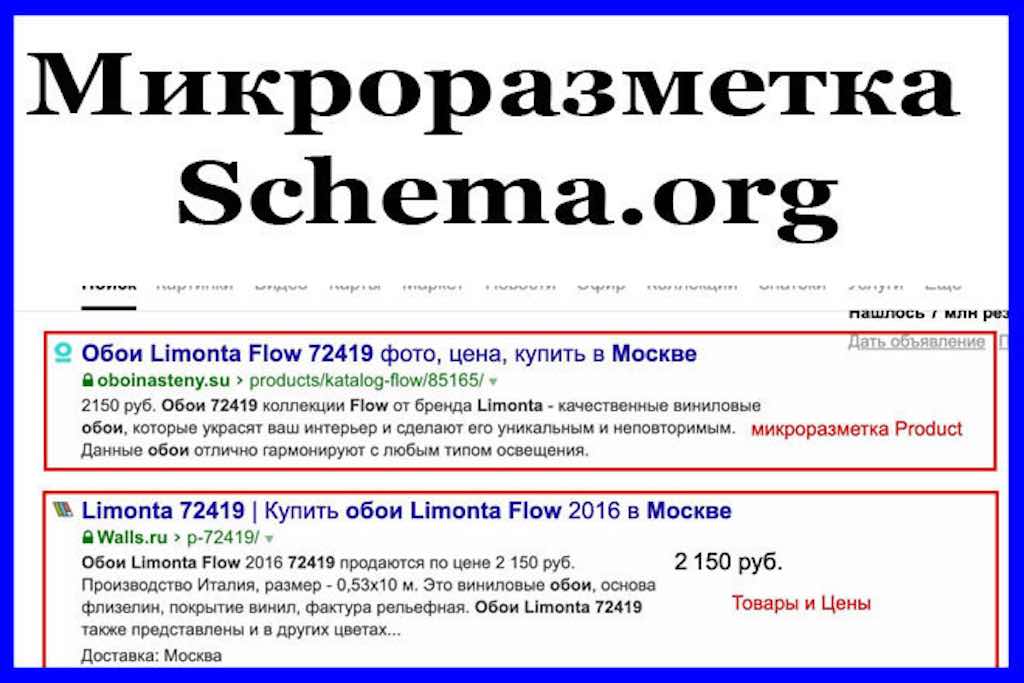

Микроразметка сайта

Стандарт, который используется для структурной оптимизации семантического ядра, называется микроразметкой. Данный стандарт поддерживают поисковые системы Яндекс, Google, Yahoo, Bing начиная с 2011 года.

Микроразметка сайта предназначена для того чтобы обеспечить помощь поисковым роботам в более точной идентификации и структурировании информации на портале. Делается микроразметка путем добавления в HTML-код специальных тегов, где должна содержаться исключительно та информация, которая будет полезной.

Их размещение производится непосредственно в код страницы, поэтому не требуется формирование каких-то отдельных файлов.

Метатеги для индексации сайта

С помощью метатегов можно также очень эффективно управлять индексацией. Вот основные из них:

Robots

Метатег Robots очень схож по своему функциональному назначению с файлом robots.txt, только в отличии от него относится не ко всему сайту, а к конкретной странице. Пример команд для поисковых роботов с помощью файла robots:

<meta name=»robots» content=all»/> — команда разрешает роботам индексировать текст и ссылки на конкретной странице сайта.

<meta name=»robots» content=»noindex»/> — запрещено индексировать текст на странице.

<meta name=»robots» content=»nofollow»/> — запрещено переходить по ссылкам на странице.

<meta name=»robots» content=»none»/> — запрещено переходить по ссылкам на странице и индексировать текст.

Nofollow

Атрибут rel=»nofollow» запрещает роботам поисковых систем переходить по определенным ссылкам указанным в этом атрибуте.

Noindex

Мета тег Noindex закрывает поисковым системам возможность осуществлять процесс индексации того фрагмента страницы сайта, который по каким-либо причинам необходимо вывести из поля зрения поисковых роботов. Иными словами, при использовании данного тега часть страницы запрещается к прочтению и обработке поисковым ботом.

Канонический URL

Когда на сайте появляется большое количество страниц с одинаковым по смыслу контентом, поисковые роботы начинают путаться в нем, не понимания какой из них наиболее релевантен. В результате такие страницы «склеиваются» между собой и у них проседают позиции.

Для того, чтобы улучшить позиции этих страниц их нужно расклеить. Выполняется это с помощью канонических URL.

Например: если есть на сайте страница https://www.primer.ru/catalog/page-3, но необходимым к показам в поисковой выдаче является страница https://www.primer.ru/catalog, то нужно прописать у неё канонический адрес, который будет говорить роботам, что эта страница самая главная из всех и она должна присутствовать в поиске. Делается это так 👇

<Link rel=»canonical» href=»https://www.primer.ru/catalog«/>

И так нужно прописать все канонические (важные) страницы.

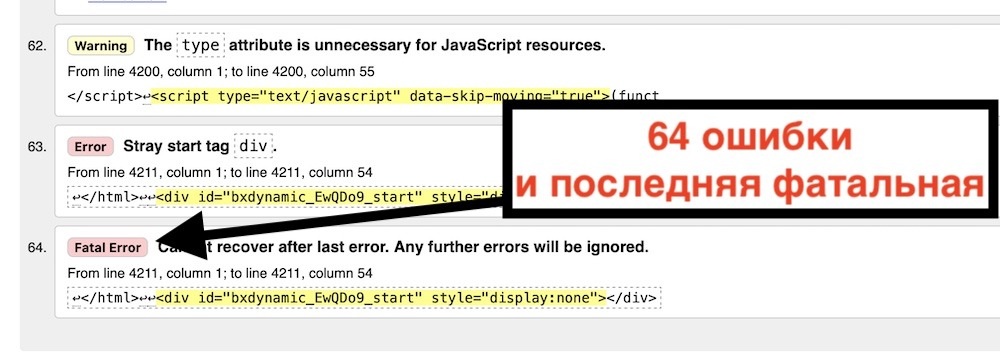

Валидная верстка

Чистый и валидный html код (верстка) позволяет поисковым роботам лучше ориентироваться на сайте и индексировать его. Серьезной проблемой являются фатальные ошибки в коде — fatal errore 👇

Как правило, поисковый робот доходит до них и покидает сайт. Нужно внимательно следить за валидностью своего html кода и вовремя убирать ошибки верстки. Вот отличный сервис проверки валидности кода — https://validator.w3.org

Оптимизация изображений

Продвижение сайта картинками очень эффективный способ увеличить трафик на сайт. Но для этого нужно грамотно оптимизировать изображения на сайте. Речь идет о прописывании всех файлов с фотографиями специальными транслитерированными ключевыми словами с идентификатором foto на конце.

Например: https://hozyindachi.ru/wp-content/uploads/2018/06/prodvizhenie-sajta-kartinkami.jpg

Кроме этого нужно оптимизировать размер всех изображений, чтобы они не создавали повышенную нагрузку на сервер и не тормозили скорость загрузки сайта. В идеале каждое изображение должно весить не более 60 килобайт.

Мобильная версия сайта

Поисковый трафик с мобильных устройств относительно десктопных версий перевалил отметку в 85%. Как следствие, чтобы быть в ТОП10 выдачи Яндекс и Google сайт должен быть адаптирован под мобильные устройства.

Еще в 2016 году компанией Яндекс был запущен алгоритм «Владивосток», с помощью которого все сайты без адаптивной верстки понижались в ранжировании. В 2018 году компания Google выкатила свой алгоритм подобного содержания — Mobile-First Indexing.

Для проверки своего сайта на адаптивность можно воспользоваться этим сервисом от компании Google — https://search.google.com/test/mobile-friendly.

Структура сайта

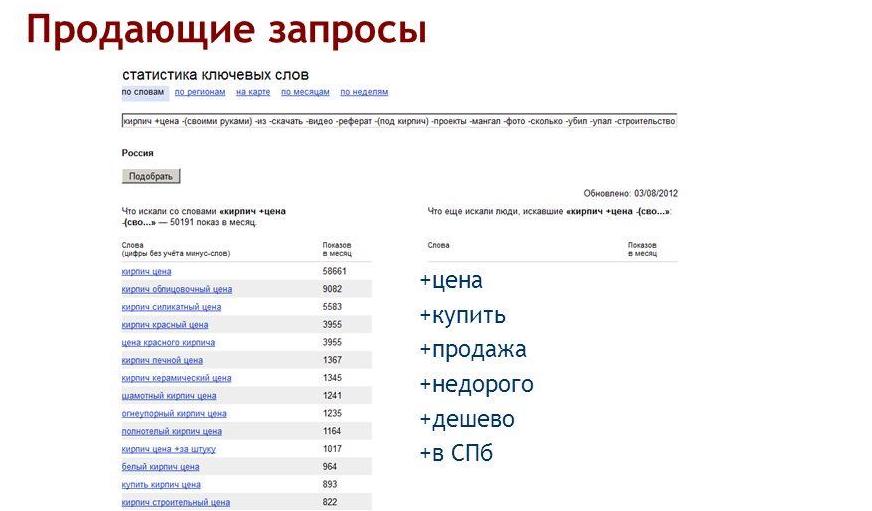

Чем разветвленнее на сайте структура, тем большее количество запросов в своем семантическом ядре она несет — читать подробнее, что такое структура сайта.

Вместо заключения

Хотите выйти в ТОП10 Яндекс и долго там оставаться? Продвигайте свои сайты и интернет-магазины исключительно белыми SEO методами! Не умеете? Могу научить! Тем, кто хочет разобраться во всех премудростях SEO, предлагаю посетить мои курсы по SEO обучению, которые я провожу индивидуально, в режиме онлайн по скайпу.

Для тех, у кого нет времени проходить обучение и самостоятельно заниматься продвижением своих интернет-магазинов, предлагаю и в этом вопросе помощь. Я могу взять ваш сайт на SEO продвижение и за несколько месяцев вывести его в ТОП10 Яндекс.

Для того чтобы убедиться в моей экспертности, предлагаю ознакомиться с моими последними SEO кейсами и только после этого заказать у меня SEO продвижение. Ниже на видео один из примеров успешного продвижения строительного сайта в Санкт-Петербурге.

Бесплатный аудит сайта

Бесплатный аудит сайта

Старт

Старт  Стандарт

Стандарт  Премиум

Премиум