Эта статья будет посвящена 10 мифам о SEO продвижении, в которые большинство из Вас верит.

10 SEO мифов в которые вы верите

SEO миф 1: Google наказывает за дублированный контент

Штрафа за дублированный контент не существует. Google не наказывает сайты за дублированный контент.

Google понимает, что дублированный контент — естественная часть Сети, и стремится к индексированию самых качественных и релевантных страниц, чтобы в результатах поиска не был повторно представлен одинаковый контент.

Если сайт не пытается манипулировать ранжированием и не состоит полностью из дублированного контента, худший сценарий при этом заключается в том, что аналогичные страницы «складываются» в индекс вместе, а вместо этого показывается альтернативная версия страницы. Проще говоря, эти страницы начинают конкурировать межу собой на одном сайте.

Специалисты по SEO могут подать поисковым системам ряд сигналов о том, какую страницу они хотели бы видеть на первых местах, используя канонические страницы, карту сайта и внутренние ссылки, указывающие на предпочтительный URL адрес.

SEO миф 2: Google принимает канонический URL как предпочтительную версию для индексирования

Просто потому, что вы указали URL как предпочтительную версию для индексирования с помощью тега canonical, это еще не значит, что эта страница будет выбрана для индексирования Google.

Rel=canonical рассматривается Google как сигнал предпочтительной страницы и не всегда соблюдается.

Такие примеры можно найти в новой версии Google Search Console в отчете Index Coverage с пометкой «Отправленный URL не выбран в качестве канонического».

Google может выбрать страницу, отличную от той, которую выбрали вы в качестве канонической, если решает, что другая страница в наборе дубликатов – лучший кандидат для показа в поиске.

В таких случаях было бы целесообразно уточнить, действительно ли выбранная вами каноническая страница является той, которую вы хотите проиндексировать. Если это так, вам нужно будет посмотреть на сигналы, о которых говорилось ранее (карты сайта, внутренние ссылки и т. д.), чтобы проверить, что они указывают на вашу предпочтительную версию.

Здесь нужно обеспечить то, что вы отправляете Google непротиворечивые сигналы относительно предпочтительной версии страницы.

SEO миф 3: сайт может пострадать от алгоритмических санкций

В недавнем интервью бывший инженер Google Фили Визе рассказал о мифе об алгоритмических санкциях:

«Одно из распространённых заблуждений касается Google Panda, Phantom и Fred, то есть качественных обновлений. Но люди думают, что это штрафы или алгоритмические санкции (но это не так).»

Дело в том, что нет такой вещи, как алгоритмическая санкция, это просто пересчет. Это похоже на большой черный ящик с формулой внутри, вы что-то вставляете, что-то выходит, то, что выходит, – это рейтинг, а то, что входит — ваш сайт.

Изменения в алгоритме — это всего лишь изменения внутри черного ящика, что означает, что то, что выходит с другой стороны, сейчас немного отличается. Означает ли это, что вы наказаны? Нет, вам так может показаться, но вы не наказаны.

Визе говорит о едва уловимой разнице, но она важна для понимания того, как работают алгоритмы поиска Google.

SEO миф 4: у Google 3 главных фактора ранжирования

В марте 2016 года большой новостью стало то, что Андрей Липатцев объявил, что ссылки, контент и RankBrain составляют 3 главных фактора ранжирования Google.

Тем не менее Мюллер с тех пор отвергнул это заявление в Webmaster Hangout, заявив, что невозможно определить наиболее важные факторы ранжирования, поскольку они изменяются от запроса к запросу и изо дня в день.

Нецелесообразно фокусироваться на отдельных сигналах ранжирования, так как алгоритмы поисковой системы слишком сложны, чтобы этот способ был полезным для концептуализации алгоритмов.

Вместо этого специалисты по SEO должны сосредоточиться на оптимизации сайтов, чтобы улучшить пользовательский интерфейс, соответствовать намерениям пользователей и в более широком смысле улучшить качество сайта, при этом следуя за новейшими разработками Google.

SEO миф 5: песочница Google применяет фильтр при индексировании новых сайтов

Следующее заблуждение касается того, как Google обращается с новыми сайтами при индексировании. У некоторых специалистов по SEO существует давняя уверенность в том, что Google фильтрует новые сайты, чтобы не дать спамерским сайтам ранжироваться сразу после запуска.

Мюллер отверг эти слухи о песочнице Google в Webmaster Hangout, где сказал, что нет такого фильтра для новых сайтов.

Тем не менее он сказал, что множество алгоритмов могут быть похожими на песочницу, но они стремятся понять, как сайт выглядит среди других, пытающихся ранжироваться по тем же запросам.

В некоторых случаях это может означать, что страницы ранжируются выше или ниже в течение определенного периода времени, в то время как алгоритмы Google определяют, как они вписываются среди конкурирующих страниц.

SEO миф 6: использование файла disavow поддерживает ссылочный профиль сайта

Исторически сложилось так, что основным элементом обязанностей SEO является сокращение профилей обратных ссылок сайта путем отказа от низкокачественных или спам-ссылок.

За эти годы алгоритмы Google стали лучше понимать эти типы низкокачественных обратных ссылок и знать, когда их следует игнорировать. В результате потребность в специалистах по SEO для поддержки и обновления файла disavow значительно уменьшилась.

В сентябре 2017 года на Brighton SEO Иллис заявил, что если обратные ссылки органичны для сайта, то крайне маловероятно, что к сайту будут применены меры вручную. Дальше Иллис сказал, что на его личном сайте нет файла disavow.

Сейчас рекомендуется использовать файл disavow только тогда, когда к сайту применяются меры вручную, чтобы удалить ссылки-нарушители.

SEO миф 7: Google ценит обратные ссылки со всех доменов с высоким авторитетом

Успешный линкбилдинг должен оцениваться по авторитету и релевантности обратных ссылок, ведущих на целевой сайт. Тем не менее обратные ссылки с доменов с высоким трастом пользуются большим спросом независимо от того, насколько они релевантны для целевого сайта.

Тем не менее еще один инсайт, полученный от Иллиса на Brighton SEO Q & A, показал, что Google учитывает контекст обратных ссылок, что означает, что специалистам по SEO, возможно, стоит придавать большее значение релевантности ссылок при переходе по ним.

Иллис считает, что приведение в порядок внутренних и внешних ссылок ценно, но важно учитывать контекст. Если статья низкого качества (не имеющая никакого отношения к вашему сайту) ведет на ваш сайт, Google проигнорирует ее, так как содержимое низкого качества и не несёт никакой смысловой нагрузки.

SEO миф 8: Google использует скорость страницы как важный сигнал для ранжирования

Google использует скорость сайта как сигнал ранжирования с 2010 года, и интуитивно можно подумать, что он хитроумно добавил её в ключевую часть алгоритмов, тем более что она стала такой важной темой в SEO.

Однако Мюллер пояснил, что, хотя в 2018 году планируется ввести обновление по скорости, Google использует скорость только для того, чтобы различать медленные страницы и те, которые находятся в нормальном диапазоне. Фактически DeepCrawl обнаружил, что Googlebot будет сканировать и индексировать страницы, которые отвечают до трех минут.

Скорость может также косвенно влиять на ранжирование через обратную связь от пользовательского опыта, например посетителей, уходящих со страницы, которой требуется слишком много времени для загрузки. Но тем не менее использование Google скорости в своих алгоритмах на данный момент является рудиментарным.

SEO миф 9: Fred – обновление алгоритма, касающееся качества ссылок

Google постоянно обновляет свои алгоритмы поиска со средней скоростью 2-3 раза в день. Обновление алгоритма Fred в марте 2017 года считалось, связанным с качеством ссылок.

Тем не менее, Иллис дал понять, что не было никакого конкретного обновления алгоритма, такого как Panda или Penguin, — на самом деле он назвал Fred колебаниями ранжирования в шутку.

Далее Иллис сказал, что 95-98 процентов этих текущих обновлений не имеют большого практического значения для веб-мастеров. Колебания всегда случаются, но вы должны сосредоточиться на создании высококачественного сайта, чтобы много людей говорило о вашем бренде с помощью естественных ссылок, социальных сетей и т. д.

SEO миф 10: Краулинговый бюджет неважен

Краулинговый бюджет — сложная и спорная тема, но ее игнорируют те, кто переоценивает способность Google сканировать все страницы на определенном сайте.

Google может одновременно сканировать все страницы на небольших и средних сайтах (до 200 000 страниц). Тем не менее краулинговый бюджет является актуальной проблемой для тех, кто управляет крупными корпоративными сайтами, потому что им необходимо обеспечить регулярное сканирование важных страниц.

Один из способов проверить, сканирует ли Google большую часть вашего сайта, — посмотреть, не сканирует ли Googlebot много страниц 404, так как это будет указывать на то, что большинство важных страниц уже просканировано.

Вместо заключения

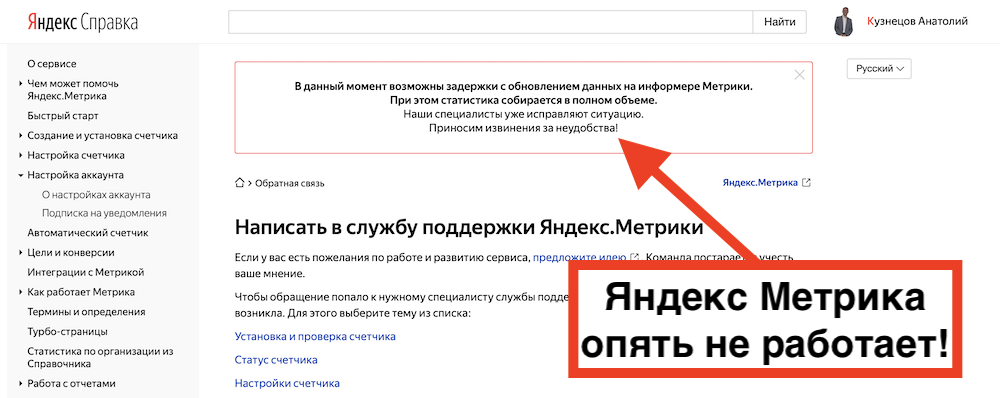

Хотите выйти в ТОП10 Яндекс и долго там оставаться? Продвигайте свои сайты и интернет-магазины исключительно белыми SEO методами! Не умеете? Могу научить! Тем, кто хочет разобраться во всех премудростях SEO, предлагаю посетить мои курсы по SEO обучению, которые я провожу индивидуально, в режиме онлайн по скайпу.

Для тех, у кого нет времени проходить обучение и самостоятельно заниматься продвижением своих интернет-магазинов, предлагаю и в этом вопросе помощь. Я могу взять ваш сайт на SEO продвижение и за несколько месяцев вывести его в ТОП10 Яндекс.

Для того чтобы убедиться в моей экспертности, предлагаю ознакомиться с моими последними SEO кейсами и только после этого заказать у меня SEO продвижение. Ниже на видео один из примеров успешного продвижения строительного сайта в Санкт-Петербурге.

Бесплатный аудит сайта

Бесплатный аудит сайта

Старт

Старт  Стандарт

Стандарт  Премиум

Премиум