Есть два способа запретить роботу поисковых систем сканировать весь ваш сайт или его часть. Во-первых, поместите тег meta Robots в раздел «head» html-файла (что сделает его эффективным только для страниц, на которых вставлен тег). Второй — написать специальный файл с инструкциями под названием «robots.txt» и поместить его в корневой каталог сайта.

Роботы-скроллеры полезны с точки зрения SEO продвижения, поскольку понятно, что паук поисковой системы имеет определенный лимит страниц в вашем домене для индексации. Каким бы ни было это ограничение, не стоит растрачивать резерв своей поисковой системы, позволяя ей индексировать файлы, которые не оптимизированы или не предназначены для просмотра поисковиками.

Также необходима потребность в файле robots.txt, чтобы роботы не перегружали серверы быстрыми запросами или неоднократно переиндексировали одни и те же файлы. Если по какой-либо причине на вашем сайте есть дублированный контент, его можно контролировать, чтобы он не индексировался. Это поможет вам избежать санкций за дублирование. Кроме того, нужно исключить содержимое личных или секретных папок из индексации.

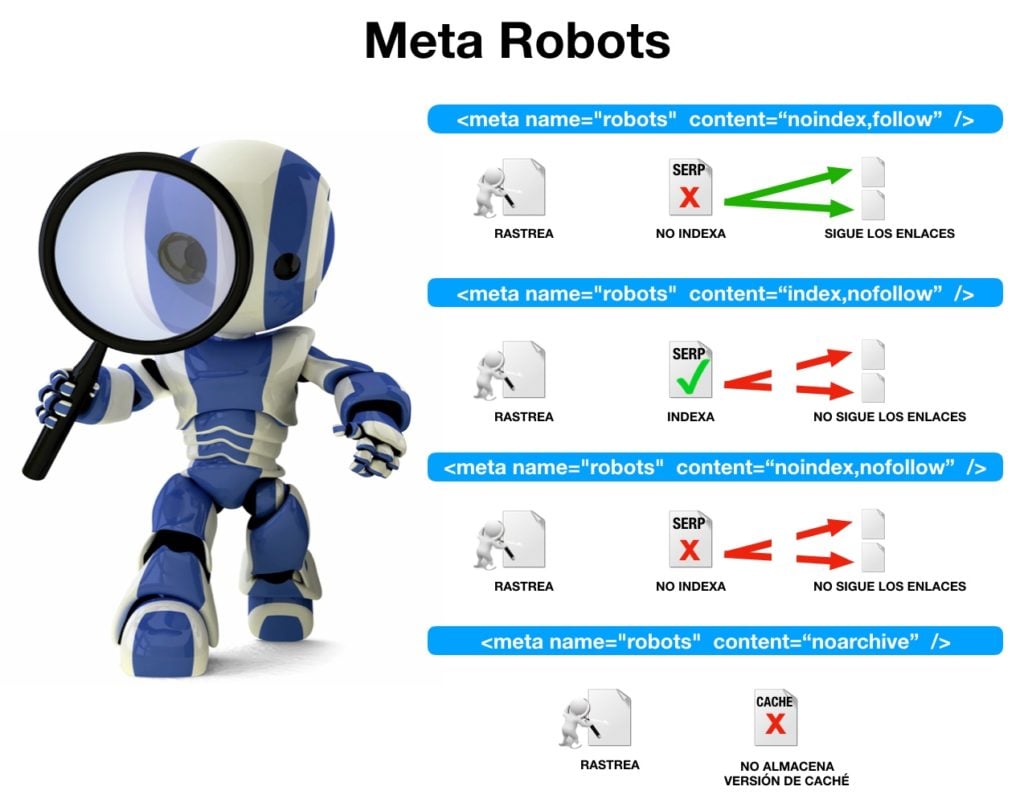

Тег meta Robots

Meta-тег Robots — это тег в html-коде сайта, который указывает роботам поисковых систем, какие страницы сайта им следует индексировать, а каких — избегать. Используйте robots, чтобы указать любые страницы, которые вы хотите убрать из индексов поисковых систем (например, формы заказов и гостевые книги).

В html-коде веб-страницы пример meta-тега Robots должен быть таким: «meta name=»роботы» content=»индексировать, следить» /».

«Индекс» означает, что поисковой системе разрешено индексировать страницы сайта, а «следовательно» означает, что ей разрешено переходить по ссылкам и обнаруживать новые страницы.

Вы можете указать поисковой системе не индексировать определенные страницы, изменив содержимое тега Robots на «noindex, follow» или «noindex, nofollow», если вы также не хотите, чтобы она переходила по ссылкам на странице.

Meta-тег Robots должен быть помещен в раздел «head» вашего html-кода. Некоторые поисковые системы не поддерживают этот тег и требуют, чтобы использовался только протокол исключения роботов (который поддерживается каждым поисковиком).

Теги Googlebot и bingbot

Пауки поисковых систем Google и Bing называются GoogleBot и bingbot соответственно. При чтении ваших html-страниц эти «боты» будут искать специальные теги meta, называемые meta GoogleBot и meta bingbot. Эти метатеги предназначены для предоставления веб-мастерам, не имеющим доступа к корневому каталогу домена (для размещения файла «robots.txt», обсуждаемого позже), возможность закрыть части своих сайтов от сканирования ботами.

Синтаксис следующий: «meta name=»googlebot» content=»noindex» /».

Вы можете использовать либо «noindex», либо «nofollow», либо «noarchive», либо «nosnippet», либо любую комбинацию этих значений, разделенных запятыми, для атрибута «content». Например, «nosnippet, noarchive» укажет Google не отображать фрагменты вашей страницы в своей поисковой выдаче и не архивировать копию документа).

Тот же синтаксис можно использовать на вашей странице для bingbot: «meta name=»bingbot» content=»noindex, nofollow»».

Имейте в виду, что GoogleBot распознает четыре упомянутые выше команды, а bingbot — только две из них (noindex, nofollow). Такие команды, как «index» или «follow», будут игнорироваться.

Протокол исключения роботов (файл robots.txt)

Протокол исключения роботов, обычно называемый файлом Robots.txt, — это еще один метод, позволяющий администраторам веб-сайтов указывать посещающим роботам, какие части их сайта не следует индексировать.

Если краулер поисковой системы обращается к ресурсу, то он сначала проверяет наличие файла с именем «robots.txt» в корневом каталоге сайта (www.yoursite.com/robots.txt). Если этот документ будет обнаружен, паук будет следовать инструкциям, содержащимся в нем.

Файл robots.txt содержит информацию в следующем формате:

«Пользовательский агент: *

Запретить: /».

Файл всегда содержит два поля, первое — имя робота, к которому он обращается, второе — каталог (или каталоги), просмотр которых запрещен.

Строка с инструкцией «Запретить» указывает URL-адреса, к которым у указанных роботов нет доступа.

Здесь «*» означает всех роботов, а «/» — всех URL-адресов. При указании URL-адресов нужно писать все, что следует за вашим корневым (домашним) URL-адресом, включая косую черту. Таким образом, использование только косой черты означает сам ваш домашний каталог. Таким образом, это читается как «Нет доступа для любой поисковой системы к любому URL».

В следующем примере ничто не ограничено для робота Googlebot, поэтому он может просматривать любой файл и каталог:

«# Гарантирует доступ для робота Googlebot (символы после # и до новой строки

# считаются комментариями).

Агент пользователя: Googlebot

Disallow:».

Если вам когда-нибудь понадобится проинструктировать несколько пауков в нескольких каталогах, вы можете передать эти команды:

«Агент пользователя: Googlebot

Disallow:

Пользовательский агент: *

Disallow: /cgi-bin/».

Это запретит всем паукам сканировать ваш каталог «cgi-bin» (где большинство веб-мастеров хранят серверные скрипты), однако GoogleBot будет иметь к нему доступ.

Дополнительная информация о robots.txt

Имя файла robots.txt должно быть в нижнем регистре, даже если ваш сайт размещен на платформе, нечувствительной к регистру, такой как Windows (например, «Robots.txt» неверно).

Подстановочные знаки не поддерживаются в обоих полях. «*» может использоваться только в синтаксисе команды поля User-agent для обозначения «все». Googlebot — единственный робот, который теперь поддерживает некоторые расширения файлов с подстановочными знаками, что дает вам возможность исключать определенные типы файлов из индексации. Для получения дополнительной информации посетите http://www.google.com/webmasters/.

Функциональность веб-сайта не пострадает, когда файл robots.txt отсутствует или пуст. Хотя это открывает доступ всем роботам для сканирования всех областей и страниц вашего сайта. Однако на некоторых серверах и сканерах отсутствие файла robots.txt может привести к ошибке 404 и перенаправить робота на страницу с ошибкой 404 по умолчанию. Робот считает, что это ваш файл robots.txt, и его поведение станет непредсказуемым. Поэтому рекомендуется всегда иметь файл robots.txt.

Для каждого домена может поддерживаться только один файл «robots.txt», и он должен быть размещен в корневом каталоге вашего сайта, то есть в том же каталоге, где находится ваша домашняя страница.

Владельцы веб-сайтов, у которых нет прав администратора или доступа для записи к URL-адресу корневого домена, вероятно, не смогут использовать файл robots.txt. В таких ситуациях вы можете попытаться использовать тег meta Robots.

Для указания доступа к разным User-agent необходимы отдельные строки, а поле Disallow robots.txt не должно содержать более одной команды в строке, хотя количество строк не ограничено. Поля User-agent и Disallow могут повторяться с разными командами любое количество раз. Пустые строки также не будут работать в одном наборе записей обеих команд.

Используйте нижний регистр для всего содержимого файла «robots.txt» (за исключением случаев, когда вам нужно указать каталог или имя файла в верхнем регистре на платформе с учетом регистра, например Unix).

Вместо заключения

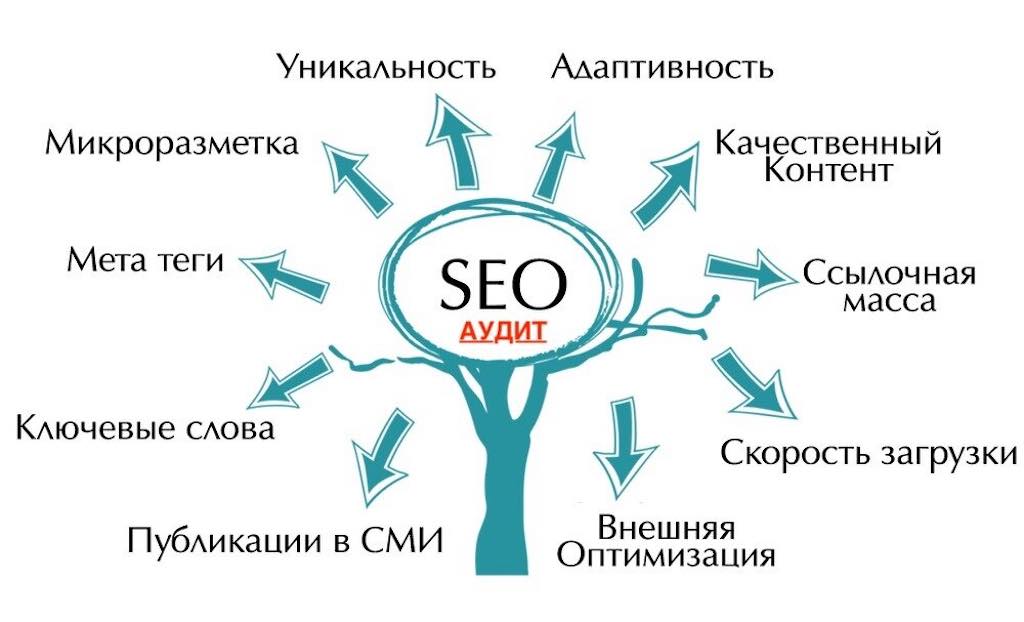

Хотите выйти в ТОП10 Яндекс и долго там оставаться? Продвигайте свои сайты и интернет-магазины исключительно белыми SEO методами! Не умеете? Могу научить! Тем, кто хочет разобраться во всех премудростях SEO, предлагаю посетить мои курсы по SEO обучению, которые я провожу индивидуально, в режиме онлайн по скайпу.

Для тех, у кого нет времени проходить обучение и самостоятельно заниматься продвижением своих интернет-магазинов, предлагаю и в этом вопросе помощь. Я могу взять ваш сайт на SEO продвижение и за несколько месяцев вывести его в ТОП10 Яндекс.

Для того чтобы убедиться в моей экспертности, предлагаю ознакомиться с моими последними SEO кейсами и только после этого заказать у меня SEO продвижение. Ниже на видео один из примеров успешного продвижения строительного сайта в Санкт-Петербурге.

Бесплатный аудит сайта

Бесплатный аудит сайта

Старт

Старт  Стандарт

Стандарт  Премиум

Премиум