Добрейшего всем денечка! С вами Кузнецов Анатолий и сегодня я затрону очень важную тему и боль интернет-магазинов, на которых в вебмастере Яндекс высветилась надпись: «найдены страницы дубли с GET-параметрами». Эти дубли действительно сильно портят жизнь сайтам и ухудшают их ранжирование в поисковой системе Яндекс.

Чем опасны страницы дубли с GET-параметрами для SEO

Любые возникающие дубли страниц на сайте могут попасть в индекс вместо главных (рабочих и продающих) страниц, а также замедлить обход и индексацию роботами скроллерами. Если объяснять по простому, то дубли страниц — это практически полностью похожие друг на друга страницы сайта с одинаковым содержимым.

Когда поисковые роботы видят такие дубли, они не могут понять, какая страница наиболее релевантна и могут исключить из индекса обе, либо проиндексировать не ту которая нужна вам. Это и является основной болью.

Страницы с GET-параметрами влияющие на содержание не являются дублями. А если в свою очередь GET параметр не изменяет контент (URL) на конкретной странице, то он является дублирующим и его необходимо скрыть от индексации поисковыми роботами.

Что такое страницы дубли с GET-параметрами

GET-параметр — это параметр, который передается серверу в URL страницы. Он начинается с вопросительного знака. Если URL содержит более одного параметра, то эти параметры разделяются знаком «&». Самый частый случай появления дублей из-за незначащих параметров — метки для задач веб-аналитики.

Например, utm_source, utm_medium, from. Такими метками владельцы сайтов привыкли помечать трафик. Фактически эти URL одинаковые, на них опубликован одинаковый контент. Но формально адреса разные, так как различаются GET-параметрами в URL. Соответственно, и поиск тоже может посчитать их разными. Такие страницы и называются дублями с незначащими GET-параметрами.

Зачем нужно постоянно отслеживать страницы дубли с GET-параметрами

- Для уменьшения скорости обхода поисковыми роботами. Когда найдены страницы дубли с GET-параметрами, причем когда таких страниц много, роботы скроллеры затрачивают больше времени на их переобход, а делать они это не любят. В результате основные продающие страницы, карточки товаров, услуги и прочие, будут индексироваться долго, либо вообще не попадать в индекс.

- Улучшить управляемость ботов. Удаление дублей с GET-параметрами исключает произвольный выбор роботами релевантных страниц. В индекс попадают те страницы, которые и должны.

- Улучшить ранжирование сайта (интернет-магазина). Если страницы дубли с GET-параметрами не удалены через дерективу clean-param, то индексирующие роботы скроллеры будут считать такой контент разным, не объединяя его в поисковой выдаче. В таком случае, неагрегируемые сигналы будут поступать поисковым ботам от каждой такой страницы, это размывает вес этих страниц, который наоборот нужно аккумулировать на одной из них и ухудшает общее ранжирование.

- Уменьшить нагрузку на сайт. Обход дополнительных дублирующих страниц увеличивает обращения на сервер от ботов и создает на нем повышенную нагрузку.

Как удалить страницы дубли с GET-параметрами

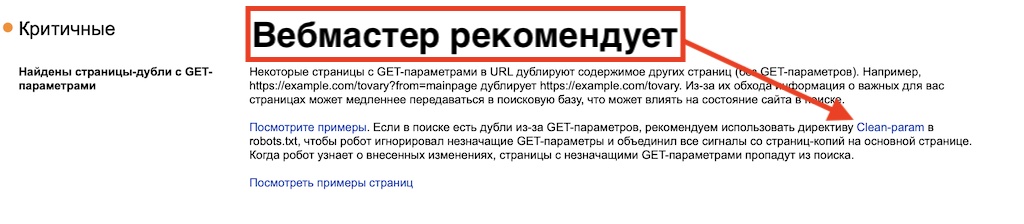

Самый простой и рабочий метод удаления дублей страниц, это внести изменения в файл Robots.txt, через директорию и правила Clean-param или Disallow. Собственно это предлагает сделать и сам Яндекс в Вебмастере:

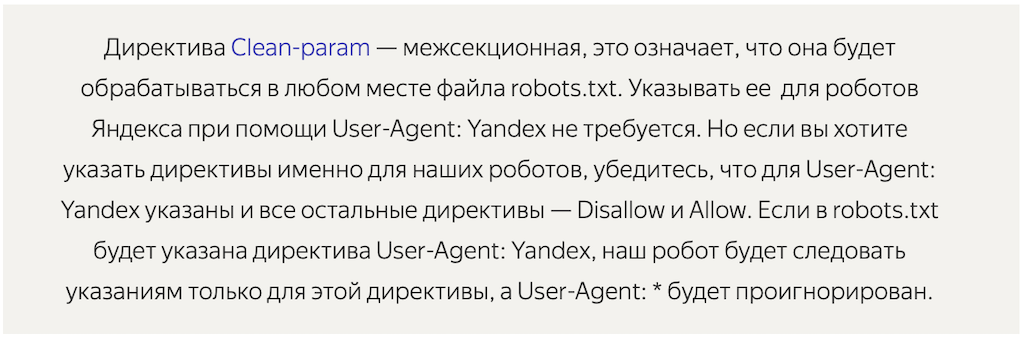

Что такое деректива clean-param

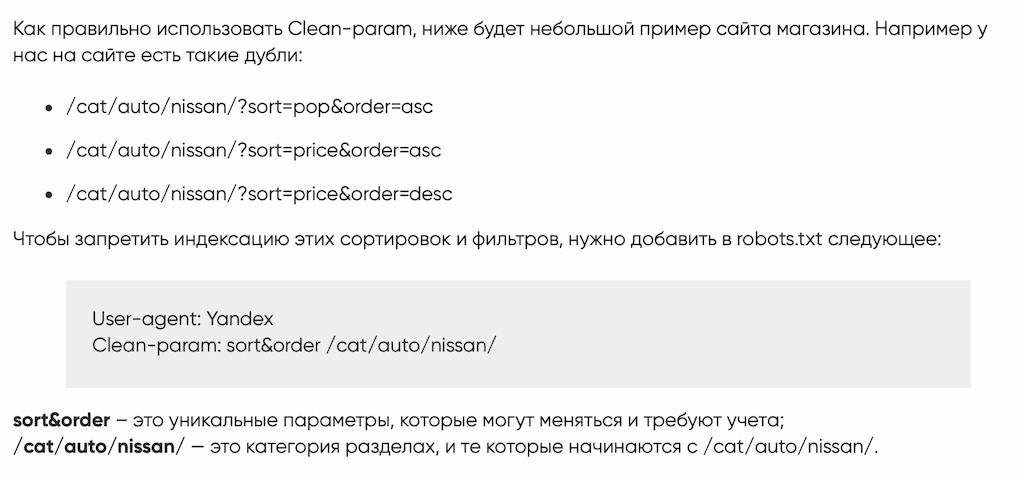

Как использовать Clean-param

Если у вас нет позможности добавить на сайт дерективу Clean-param, то необходимо прописать для каждой дублированной страницы канонические параметры. Но этот метод не уменьшит нагрузку на сайт, так как роботы Яндекса будут обрашаться к команде rel=canonical и обходить страницы дублей.

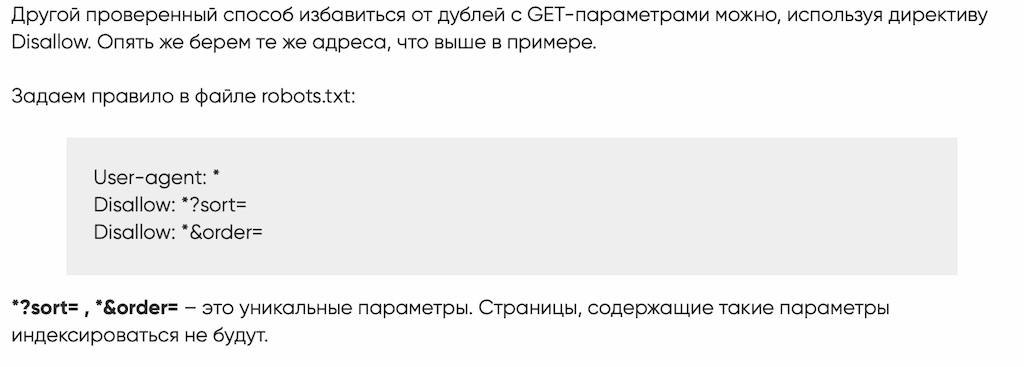

Если оба способа вам не подходят, то можно жестко перекрыть доступ роботам к таким страницам, выключив их из индекса дерективой Disallow. В таком случае поисковик не будет получать никаких сигналов от этих страниц.

Как использовать директиву Disallow

Бесплатная проверка сайта на SEO ошибки

Специально для читателей моего блога я разработал бесплатный сервис проверки сайта на наличие технических и SEO ошибок, которые сдерживают его продвижение в поисковых системах Яндекс и Google. Устранив эти проблемы, ваш сайт вздохнет полной грудью и оставит конкурентов позади! Посмотрите короткое видео о работе сервиса и проверяйте свой WEB ресурс:

Вместо заключения

Хотите выйти в ТОП10 Яндекс и долго там оставаться? Продвигайте свои сайты и интернет-магазины исключительно белыми SEO методами! Не умеете? Могу научить! Тем, кто хочет разобраться во всех премудростях SEO, предлагаю посетить мои курсы по SEO обучению, которые я провожу индивидуально, в режиме онлайн по скайпу.

Для тех, у кого нет времени проходить обучение и самостоятельно заниматься продвижением своих интернет-магазинов, предлагаю и в этом вопросе помощь. Я могу взять ваш сайт на SEO продвижение и за несколько месяцев вывести его в ТОП10 Яндекс.

Для того чтобы убедиться в моей экспертности, предлагаю ознакомиться с моими последними SEO кейсами и только после этого заказать у меня SEO продвижение. Ниже на видео один из примеров успешного продвижения строительного сайта в Санкт-Петербурге.

Бесплатный аудит сайта

Бесплатный аудит сайта

Старт

Старт  Стандарт

Стандарт  Премиум

Премиум