Доброго всем времени суток! Кузнецов Анатолий на связи и сегодня я решил поделиться с вами информацией, которая еще несколько лет назад меня самого сильно интересовала. Вопрос у меня был следующий: «нужно ли прописывать директиву host в файле Robots.txt». И самое главное, что будет если директиву host прописать неправильно?

Что такое директива host и зачем она нужна

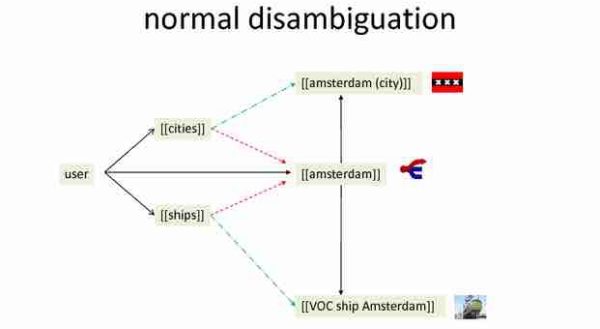

Host — специально разработанная директива для поисковых роботов Яндекса, которая указывает им какое главное зеркало на сайте, а какое второстепенное.

Очень часто использовали директиву host во времена перехода сайтов на безопасное https соединение. До применения SSL сертификатов и https протоколов, сайты располагались по адресу http. Пример моего сайта:

- Было: https://hozyindachi.ru

- Стало: https://hozyindachi.ru

С добавлением буквы «S» сайт начинал работать через защищенное соединение и, по сути, становился новым, дублирующим сайтом. Но как мы все понимаем, дублирование и хорошее ранжирование понятия не совместимые в Яндекс. И чтобы избежать проблем, нужно один сайт делать зеркалом второго. Именно для этой процедуры и была создана директива host, которую прописывали в файле Robots.txt.

Как прописывать директиву host в robots.txt

Раньше её прописывали так:

User-agent:

Yandex Disallow: /page

Host: site.ru

Этот код говорил роботам Яндекса, что основной сайт находиться по адресу site.ru и он является главным зеркалом. В моем случае это был сайт https://hozyindachi.ru. Ну а тот, который был раньше https://hozyindachi.ru, подклеивался и не учитывался роботами. Так все и работало до 2018 года и вся эта процедура называлась «деликатный переезд» c http на https.

Уверен, что многие помнят те веселые времена, когда после безграмотного перехода на htpps протокол у сайта обваливался трафик и терялись позиции.

В 2018 году Яндекс отменил директиву host

12 марта 2018 в блоге вебмастера Платон Щукин опубликовал текст следующего характера, отменяющий директиву host по следующим причинам.

Информация из Яндекс Вебмастер:

Директива Host позволяла сохранить доступность старого сайта на период переезда, однако ее использование было также сопряжено с некоторыми неудобствами. Например, необходимо было проверять, что в директиве Host всех зеркал указан один и тот же сайт, иначе переезд мог произойти некоректно. В связи с этим было решено отказаться от использования директивы Host — теперь переезд будет выполняться только при помощи редиректа HTTP-301. Это также упростит совмещение переезда в Яндексе и других поисковых системах.

Что теперь нужно делать?

Новый план работ рекомендованный Яндексом:

1. Добавьте новый домен в Вебмастер (в том числе сайт по протоколу HTTPS, если переезд выполняется на HTTPS) и убедитесь, что он не склеен в группу зеркал с другим сайтом. Если это так, воспользуйтесь инструментом «Отклейка зеркал», чтобы расклеить сайты. После окончания расклейки переходите ко второму пункту.

2. Настройте редирект 301 со страниц старого сайта на аналогичные страницы нового. При этом я рекомендую учитывать несколько важных моментов:

— сайты должны совпадать между собой структурно, поэтому страницы старого сайта должны выполнять редирект именно на аналогичные страницы нового сайта. Если же структура сайта при переезде изменилась, Вы можете установить редирект со страниц старого сайта на аналогичные страницы нового, а с них установить редирект на нужные адреса. Наши рекомендации по смене структуры сайта описаны в разделе Помощи.

— оба сайта должны быть доступны роботу. Проверьте, что в robots.txt обоих сайтов содержатся одинаковые правила, ведь если будут запрещены разные страницы, это может привести к различию контента. Если сайты используют один и тот же файл robots.txt, то файл sitemap лучше указать по адресу нового главного зеркала, так как после переезда индексироваться будет именно он.

— убедитесь, что большая часть страниц сайтов доступна и отвечает кодом HTTP-200 ОК или кодом редиректа 301. Если на доменах существенная доля страниц будет недоступна из-за кода ответа 404, это может помешать переезду. В таком случае недоступные страницы можно запретить к индексированию в файле robots.txt, чтобы робот-зеркальщик не посещал их при сверке контента.

3. Проверьте, что все зеркала в группе выполняют редирект на желаемое главное зеркало. Это также относиться к версиям «с www» или «без www».

Когда все необходимые настройки будут внесены, в панели Яндекс.Вебмастера старого адреса отправьте заявку на переезд сайта. Если заявка была успешно принята, значит, настройки выполнены корректно и сайты смогут склеиться. Процесс склейки был значительно ускорен и сейчас может занимать от нескольких дней до 3 недель.

Замечу, что завершение переезда не означает, что все страницы сайта сразу попадут в поиск по адресу главного зеркала. Страницы неглавного зеркала будут участвовать в поиске какое-то время, пока аналогичные страницы главного зеркала не будут проиндексированы. Постепенно, по мере обхода нужного сайта, неглавное сможет пропасть из поиска.

Зачастую также возникает вопрос, почему в Яндекс.Вебмастере у неглавного зеркала большое число страниц в списке «Загруженных», и это число может даже увеличиваться, хотя в поиске страницы не появляются. В этом нет какой-либо ошибки: в список загруженных входят все страницы, ссылки на которые известны индексирующему роботу, поэтому данные о таких страницах вполне могут храниться в базе робота. Попадать в поиск такие страницы не будут, так как принадлежат неглавному зеркалу.

Не забудьте также, что для нового домена в Яндекс.Вебмастере необходимо добавить свой файл sitemap и установить региональность.

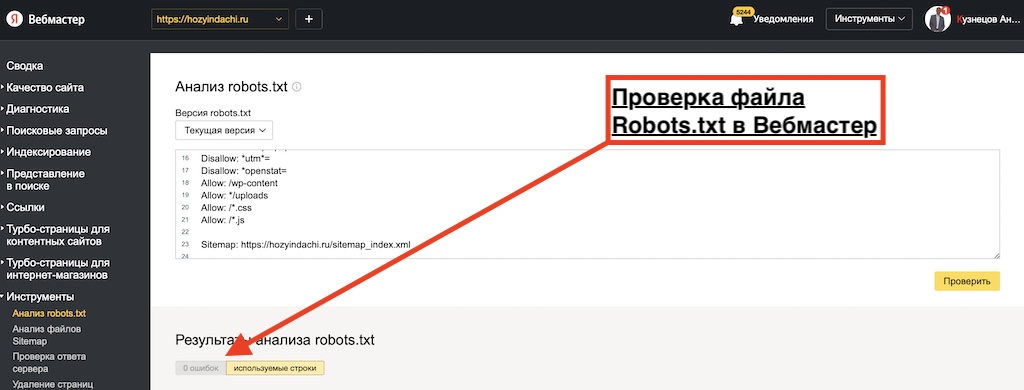

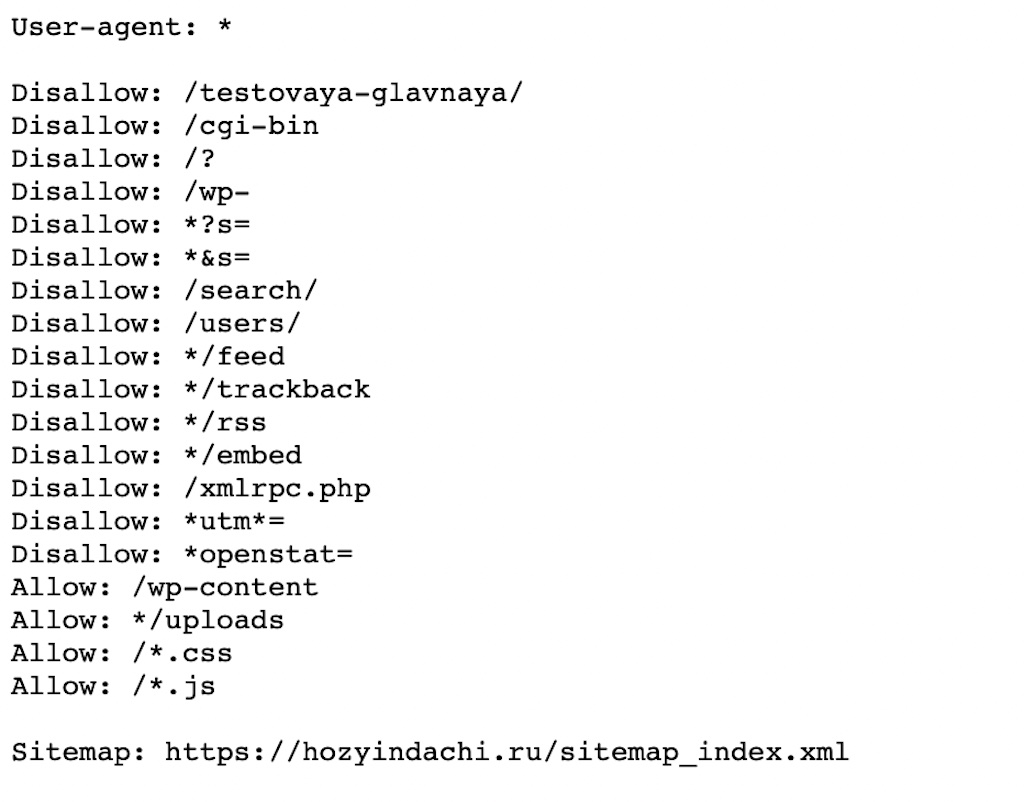

Как теперь выглядит мой файл robots.txt

Я упростил максимально свой файл robots.txt. Многие SEO-шники бегают с ним как курица с яйцом. Я и сам раньше парился и пытался его прописывать отдельно для двух поисковых систем Яндекс и Google, в надежде на лучшее ранжирование и максимальное исключение возможных дублей и усложнений в работе для роботов.

Но все оказалось полной фигней и роботам похоже фиолетово, как вы его пропишите, лишь бы не перекрыли случайно то, что точно не стоит перекрывать. В общем мой файл в Robots теперь такой и в нем полностью отсутствует директива host:

Заключение

Про директиву host в файле Robots.txt сегодня можно забыть!!! Тем более я получил официальный ответ на этот вопрос от Яндекса:

Ответ Яндекс:

Здравствуйте!

Указывать директиву Host не нужно. Её поддержка была вовсе отключена, то есть при переезде на новое доменное имя учитывается только редирект со страниц предполагаемого неглавного зеркала на аналогичные страницы желаемого главного. Подробнее об этом можно прочитать в нашем блоге.

Оцените, пожалуйста, мой ответ ❤️

—

Платон Щукин

Поддержка Яндекса

Вместо заключения

Хотите выйти в ТОП10 Яндекс и долго там оставаться? Продвигайте свои сайты и интернет-магазины исключительно белыми SEO методами! Не умеете? Могу научить! Тем, кто хочет разобраться во всех премудростях SEO, предлагаю посетить мои курсы по SEO обучению, которые я провожу индивидуально, в режиме онлайн по скайпу.

Для тех, у кого нет времени проходить обучение и самостоятельно заниматься продвижением своих интернет-магазинов, предлагаю и в этом вопросе помощь. Я могу взять ваш сайт на SEO продвижение и за несколько месяцев вывести его в ТОП10 Яндекс.

Для того чтобы убедиться в моей экспертности, предлагаю ознакомиться с моими последними SEO кейсами и только после этого заказать у меня SEO продвижение. Ниже на видео один из примеров успешного продвижения строительного сайта в Санкт-Петербурге.

Бесплатный аудит сайта

Бесплатный аудит сайта

Старт

Старт  Стандарт

Стандарт  Премиум

Премиум