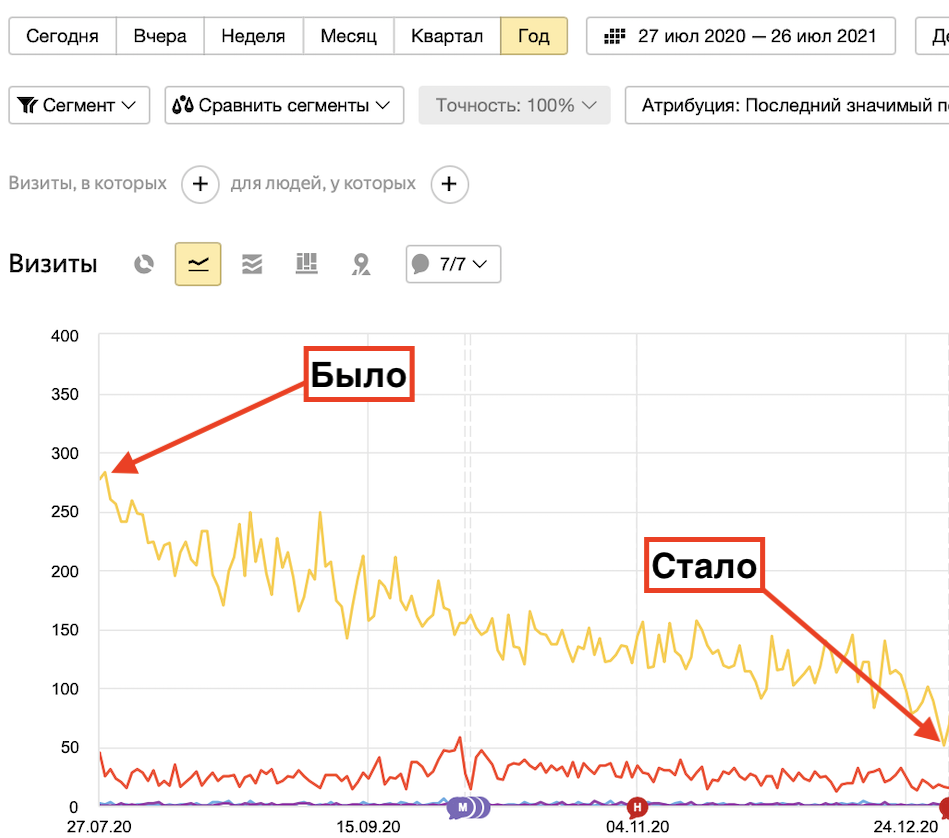

Привет, Друзья! Больше года назад на моем сайте упал трафик с Гугла практически в ноль. Раньше посещаемость была одинаковая 50/50 с Яндекса и Google и эта статистика подтверждала, что я выполняю SEO продвижение правильно.

Но в один из дней, что-то пошло не так и трафик с Гугл начал снижаться. Падение было не резкое и я по началу даже внимания на это не обратил. Но спустя три месяца посещаемость с 300 человек в день упала до 30. Поисковик Гугл меня разлюбил.

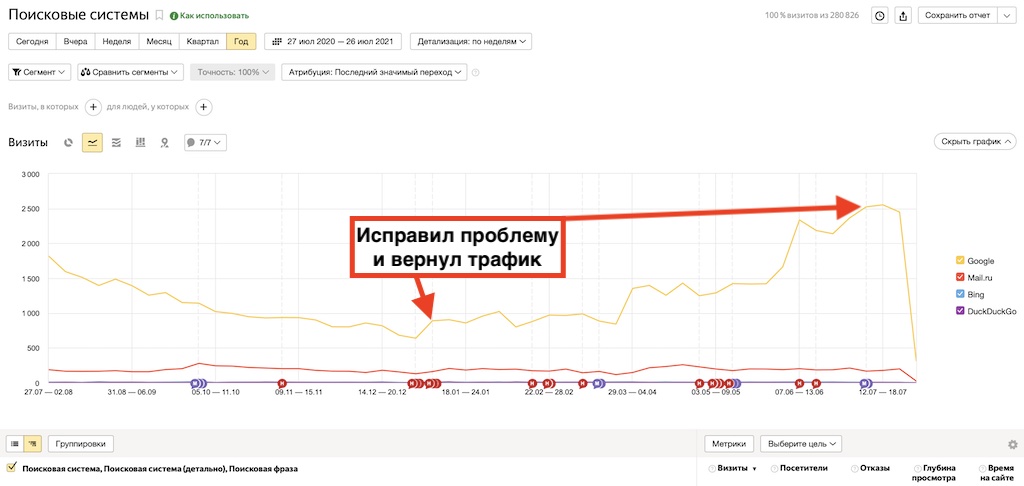

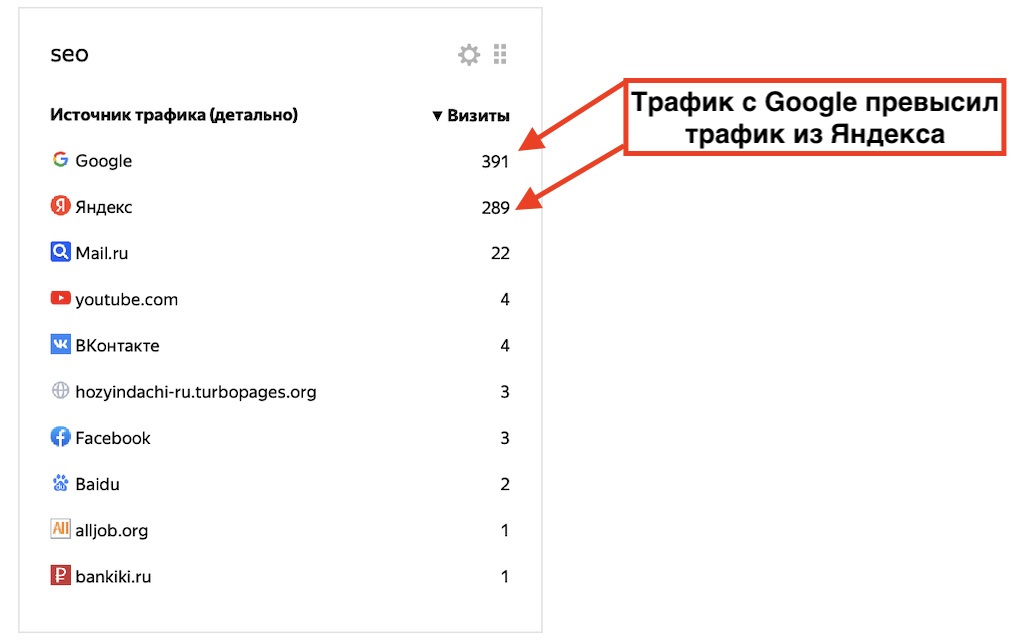

Это было фиаско. Я долго пытался понять причину провала позиций и нашел её случайно. Как только она была устранена, трафик с Гугл превысил количество посещений с Яндекса. В чем была причина снижения посещаемости в Google, читайте ниже.

Почему упал трафик с Гугла

В моих долгих поисках факапа от Гугл, я перерыл все возможные варианты. Пингвины, Панды, Колибри и прочий зоопарк из фильтров Гугла был исключен. Я не покупаю ссылки, не заспамливаю тексты и метатеги ключами, не применяю запрещенные методы продвижения (Black SEO), и на тебе, БАН!

Но откуда???? В Google Search Console не было ни автоматического бана, ни действий наложенных вручную. Но в тоже время трафик с Гугл просто рухнул камнем вниз.

Причина падения трафика с Гугл нашлась

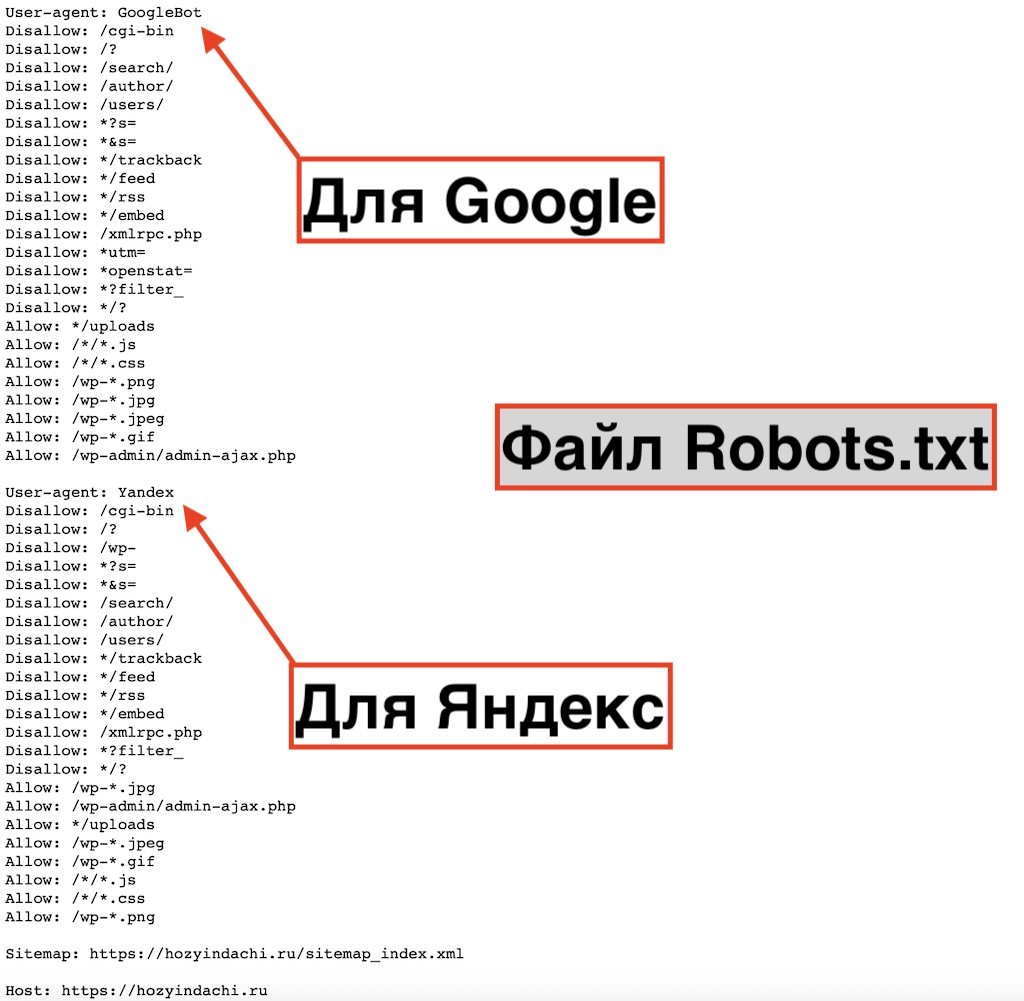

Честно говоря, я уже просто забил на Гугл и смирился с тем, что трафика на мой сайт он мне не давал. И также неожиданно как и пришло падение, поступило решение этой проблемы. Оно заключалось в том, что в файле Robots.txt для Гугл каким то чудесным образом были перекрыты CSS.

Мой сайт в глазах поисковых роботов выглядел как текстовая портянка без стилей. Я был в шоке!!! Где я только не искал проблему, но в Robots у меня даже мысли залезть не было. А что с ним может быть, если сайт уже 6 лет нормально работает????

Но у меня на тот момент был дан доступ одному из программистов, который видимо по своей оплошности накатил мне в Robots для Гугл такую бороду, отключив из индексации стили (CSS).

Причем, на тот момент у меня файл Robots.txt был очень простой и не разделялся на Яндекс и Google. Он тупо был открыт для всех, как в песне М. Круга: «Приходите в мой дом, мои двери открыты». Вот таким был Robots. Теперь я прописал его для двух систем отдельно:

Файл robots.txt для Гугл и Яндекс

Как только я это сделал, трафик с Гугл восстановился и обогнал трафик с Яндекса.

Заключение

Вот такой интересный кейс предоставил мне господин случай. Я год ломал себе голову, искал причину и не мог понять, почему упал трафик с Гугла. Оказалось как в фильме: «Не надо искать черную кошку в черной комнате, тем более если её там нет».

Друзья, относитесь внимательно к таким простым, но очень важным параметрам, как Robots, Sitemap и микроразметки. Именно из-за них ваш WEB проект может недорабатывать и недоприносить прибыль. Но помимо этих проблем, есть еще огромное количество параметров, из-за которых сайт может терять трафик и позиции. Посмотрите видео ниже и поймете о чем я говорю.

Если Вы не знаете, почему ваш сайт не продвигается, но очень хотите узнать. Я предлагаю вам для начала выполнить самостоятельно бесплатный аудит вашего ресурса. Ну а если и это не поможет, то я готов уже в качестве платного SEO аудита проанализировать ваш сайт более глубоко и подробно. Уверен, что проблему сдерживающую SEO продвижение я найду. Обращайтесь!

Бесплатный аудит сайта

Бесплатный аудит сайта

Старт

Старт  Стандарт

Стандарт  Премиум

Премиум

здравствуйте, а если еще установлен вордпресс в подпапке, для него надо отдельный роботс писать?

Здравствуйте. Если вы хотите оставить оставить открытыми все файлы сайта на подпапке, то не надо. А так нужно делать все тоже самое, что и с обычным сайтом.

обычно для поисковика robots.txt имеет рекомендательный характер. чтобы поисковик точно не индексировал то что не надо — я ставлю 301-е редиректы всегда в cms, а не вношу исключения в robots.txt.

до прочтения этой статьи я не предполагал, что поисковик реально откажется скачивать *.css и *.js.

а оказывается так вот.

наверное алгоритмы незаметно поменялись.

для своего сайта я делал https://themes-wordpress.ru/robots.txt по инструкции и в нём есть строки:

Allow: /*.js

Allow: /*/*.js

Allow: /*/*/*.js

Allow: /*/*/*/*.js

Allow: /*/*/*/*/*.js

Allow: /*.css

Allow: /*/*.css

Allow: /*/*/*.css

Allow: /*/*/*/*.css

Allow: /*/*/*/*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-*.doc

Allow: /wp-*.docx

Allow: /wp-*.pdf

я не знаю зачем разные директивы для Гугла и Яндекса. у меня всё общее. потому что есть ещё Baidu и Mail.ru

Есть многое на свете друг Горацио, что не снилось нашим мудрецам!))

Была такая же ситуация как вы описываете несколько лет назад. Только у меня этот robots вообще был наглухо перекрыт. А так как я был ноль в этом, то меня ещё и на деньги разводили, год продвигая сайт в таком состоянии))) Так что это большее фиаско чем у вас!)

Да, это ЖЕСТКО!)))