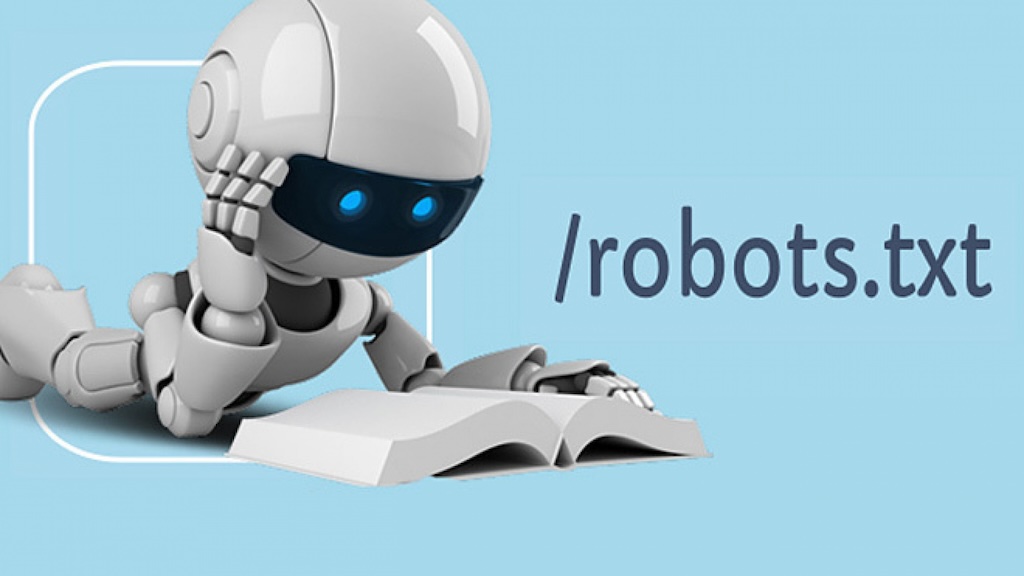

Одним из таких важных аспектов является файл robots.txt, который играет ключевую роль в управлении доступом поисковых систем к различным страницам вашего сайта. Этот файл является своего рода инструкцией для поисковых роботов, указывающей им, какие страницы следует индексировать, а какие — обходить стороной.

Однако, когда речь заходит о крупных веб-проектах, где количество страниц исчисляется сотнями и тысячами, постраничная настройка robots может оказаться как крайне полезной, так и сложной задачей. В этой статье мы подробно разберем, что такое постраничный robots, как правильно его настроить и какие ошибки следует избегать.

Что такое Robots.txt?

Файл robots.txt — это текстовый файл, который размещается в корневой директории сайта и служит для того, чтобы сообщать поисковым роботам, какие страницы и файлы они могут индексировать, а какие нет. Пример простейшего файла

robots.txtможет выглядеть так:

User-agent: *

Disallow: /private/

Здесь User-agent — это директива, указывающая на конкретного робота или группу роботов, а Disallow — настраивает запрет на индексацию указанных страниц или директорий.

Постраничный Robots: понятие и применение

Постраничный robots — это расширенная настройка файла robots.txt, которая позволяет контролировать доступ роботов к каждой отдельной странице сайта. Это может быть полезно в ситуациях, когда вам нужно ограничить или разрешить индексацию определённых страниц или даже отдельных элементов страницы.

Преимущества использования постраничного robots:

- Контроль над индексацией: Позволяет избежать дублирования контента, что положительно сказывается на SEO.

- Улучшение видимости важных страниц: Вы можете явно указать, какие страницы важны для индексации, а какие лучше исключить.

- Оптимизация нагрузки на сервер: Исключив из индексации страницы, которые не несут SEO-ценности, вы снижаете нагрузку на сервер.

Как настроить постраничный Robots.txt?

Настройка постраничного robots требует внимательного подхода, так как неправильные настройки могут привести к потерям в поисковом трафике или даже к санкциям со стороны поисковых систем.

Шаг 1: Определите цели

Перед тем как начать настройку, важно чётко определить, какие страницы должны быть индексированы, а какие — нет. Это зависит от целей вашего сайта и стратегии продвижения.

Шаг 2: Анализ сайта

Проведите детальный анализ структуры вашего сайта. Определите, какие страницы содержат уникальный контент, а какие — дублируют информацию. Для анализа можно использовать такие инструменты, как Яндекс веб-мастер, Screaming Frog, Ahrefs или Google Search Console.

Шаг 3: Настройка файла robots.txt

Пример настройки файла для постраничного контроля:

User-agent: *

Disallow: /cart/

Disallow: /search/

Allow: /products/

В данном случае роботы не будут индексировать страницы корзины и поиска, но смогут индексировать страницы с продуктами.

Шаг 4: Проверка настроек

После настройки файла robots.txt обязательно проверьте его корректность с помощью Яндекс веб-мастер, Google Search Console или других инструментов. Это позволит избежать ошибок и убедиться, что ваши страницы индексируются так, как вы планировали.

Распространённые ошибки и как их избежать

Постраничная настройка robots.txt может привести к ряду ошибок, если подходить к ней без должной внимательности.

Ошибка 1: Блокировка всех страниц

Одна из самых распространенных ошибок — случайная блокировка всех страниц сайта. Например:

User-agent: *

Disallow: /

Этот код полностью блокирует индексацию сайта, что может привести к катастрофическим последствиям для вашего SEO.

Ошибка 2: Дублирование контента

Если ваш сайт содержит страницы с одинаковым контентом (например, фильтры или сортировки), важно убедиться, что такие страницы не индексируются. Использование директивы Disallow поможет избежать дублирования.

Ошибка 3: Неправильное использование директив Allow/Disallow

Убедитесь, что вы правильно понимаете порядок обработки директив. Если вы используете Disallow и Allow одновременно, важно учитывать, что более специфичная директива имеет приоритет.

Постраничный Robots и SEO

Правильная настройка постраничного robots.txt напрямую влияет на SEO продвижение вашего сайта. Исключая дублирующие страницы и концентрируясь на уникальных, вы улучшаете качество индексации и повышаете свои шансы на высокие позиции в поисковой выдаче.

Влияние на краулинговый бюджет

Поисковые системы, такие как Google, выделяют ограниченное количество ресурсов на краулинг вашего сайта. Умелое использование постраничного robots.txt помогает эффективно распределить эти ресурсы, фокусируя внимание на действительно важных страницах.

Улучшение структуры сайта

Правильная настройка robots.txt позволяет улучшить структуру сайта в глазах поисковых систем, что также положительно сказывается на его ранжировании.

Заключение

Постраничный robots — это мощный инструмент, который, при правильной настройке, может существенно улучшить видимость вашего сайта в поисковых системах. Однако его использование требует внимательного подхода и понимания основ SEO продвижения.

Если вы хотите быть уверены, что настройка robots.txt выполнена правильно и максимально эффективно, мы рекомендуем обратиться к профессионалам. Наша компания обладает большим опытом в области SEO и веб-разработки, и мы готовы помочь вам достичь высоких результатов. Свяжитесь с нами через наш сайт, и мы предложим вам оптимальные решения для продвижения вашего проекта.

Бесплатный аудит сайта

Бесплатный аудит сайта

Старт

Старт  Стандарт

Стандарт  Премиум

Премиум