В современном мире SEO (Search Engine Optimization) является одним из ключевых факторов успеха в интернет-маркетинге. Каждый сайт, стремящийся привлечь органический трафик и занять лидирующие позиции в поисковых результатах, должен оптимизировать свой контент и структуру для удовлетворения требований поисковых систем. Одним из инструментов, способствующих взаимодействию между сайтом и поисковыми роботами, является файл robots.txt. В данной статье рассмотрим, каким образом этот файл влияет на SEO продвижение, его роль и значимость для оптимизации доступа и индексации сайта.

Что такое файл robots.txt

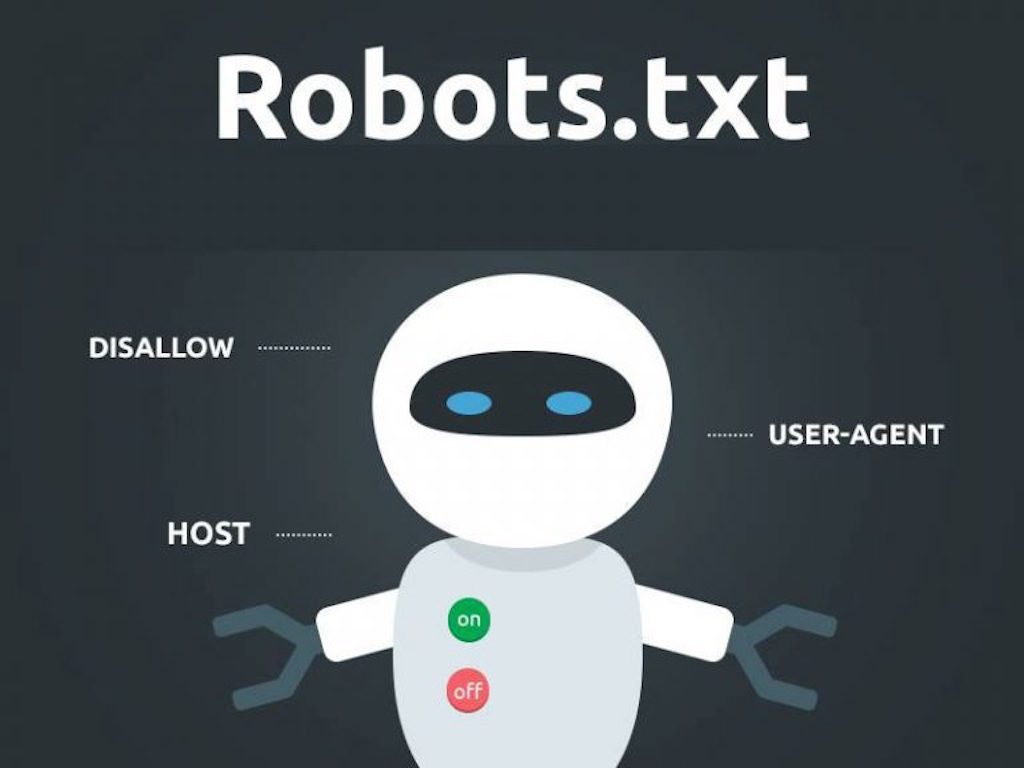

Файл robots.txt является текстовым файлом, размещаемым на корневой директории сайта. Его основное предназначение — предоставить инструкции поисковым роботам (паукам) о том, каким образом они должны взаимодействовать с содержимым сайта. Этот файл был впервые предложен в 1994 году, а стандартизирован в 1997 году. С тех пор он стал неотъемлемой частью протокола HTTP и основного инструмента для контроля доступа роботов поисковых систем.

Функции и структура robots.txt

Основная функция файла robots.txt — ограничение доступа к определенным разделам сайта и указание правил индексации контента. Поисковые роботы перед индексацией сайта сначала обращаются к этому файлу, чтобы понять, какие разделы сайта они могут обойти, а какие — нет.

Структура файла robots.txt проста. Он состоит из набора правил, каждое из которых включает две основные составляющие: «User-agent» (агент-пользователь) и «Disallow» (запретить). «User-agent» определяет тип робота, к которому относится правило, а «Disallow» указывает путь или страницы, которые робот не должен индексировать или обходить.

Пример простого файла robots.txt:

В данном примере мы указали, что любой робот («User-agent: *») не должен индексировать разделы «/private/» и «/temp/» на сайте.

Влияние robots.txt на SEO продвижение

Теперь рассмотрим, каким образом файл robots.txt влияет на SEO продвижение сайта:

- Контроль доступа: Один из основных аспектов, в которых файл robots.txt влияет на SEO, — это контроль доступа поисковых роботов к определенным частям сайта. Если есть конфиденциальные данные, временные страницы или другой контент, который не следует индексировать, размещение соответствующих инструкций в robots.txt может предотвратить их появление в поисковых результатах.

- Индексация контента: Некоторые сайты содержат различные типы контента, которые не должны быть индексированы поисковыми системами. Это может быть связано с дублирующимися страницами, динамическими параметрами URL или другими аспектами сайта, которые не нужно включать в поисковую выдачу. Файл robots.txt позволяет исключить такие разделы или страницы из индексации.

- Оптимизация Crawl Budget: Crawl Budget или бюджет сканирования — это количество страниц, которое поисковый робот готов сканировать на вашем сайте за определенный период времени. Если у сайта много бесполезных или неинтересных страниц, это может повлечь за собой снижение количества сканированных поисковыми роботами важных страниц. Размещение «Disallow» правил в robots.txt для таких страниц позволяет управлять Crawl Budget и нацеливать его на самые важные разделы сайта.

- Улучшение скорости загрузки сайта: Поисковые роботы тратят ресурсы на сканирование сайтов, и если сайт содержит много «тяжелых» страниц, это может замедлить процесс индексации и обхода. Файл robots.txt может быть использован для исключения некритичных разделов, которые могут быть обработаны позже, что улучшит скорость сканирования и обхода более важных страниц.

- Улучшение юзабилити и безопасности: Некоторые разделы сайта могут содержать конфиденциальную информацию или быть не предназначены для общественного доступа. Размещение соответствующих правил в robots.txt помогает обезопасить сайт и предотвратить возможные утечки данных.

Лучшие практики использования robots.txt для SEO

Чтобы максимально эффективно использовать файл robots.txt для SEO продвижения, следует придерживаться следующих лучших практик:

- Тщательно проверьте файл: Ошибки в файле robots.txt могут привести к непредсказуемым последствиям. Поисковые роботы могут неправильно проиндексировать ваш сайт, если неверно настроены инструкции. Поэтому всегда тщательно проверяйте файл на наличие ошибок.

- Используйте дополнительные мета-теги: Для более тонкой настройки доступа к контенту можно использовать мета-теги «noindex» и «nofollow» вместе с файлом robots.txt. «Noindex» указывает, что страница не должна индексироваться, а «nofollow» — что ссылки на данной странице не должны переходить на другие страницы.

- Избегайте использования «Disallow: /»: Некоторые веб-мастера, в попытке предотвратить индексацию всего сайта, используют «Disallow: /». Это может привести к тому, что поисковые роботы не смогут обходить никакие страницы сайта, даже те, которые должны быть проиндексированы. Вместо этого лучше указать конкретные пути, которые нужно исключить.

- Обновляйте файл при изменениях: Если вы вносите изменения в структуру сайта или переносите его на новый домен, не забудьте обновить файл robots.txt, чтобы отразить эти изменения.

Выводы

Файл robots.txt является мощным инструментом для управления доступом и индексацией вашего сайта поисковыми системами. Он позволяет контролировать, каким образом роботы взаимодействуют с вашим контентом и какие разделы должны быть проиндексированы или исключены. Правильное использование robots.txt помогает повысить качество SEO продвижения, улучшает юзабилити сайта и обеспечивает безопасность конфиденциальной информации. Однако необходимо использовать этот файл осторожно и внимательно следить за его настройками, чтобы избежать нежелательных последствий для поисковой видимости вашего сайта.

Вместо заключения

Надоела бесполезная контекстная реклама Яндекс Директ? Продвигайте свои сайты и интернет-магазины в естественном поиске! Не умеете? Могу научить! Тем, кто хочет разобраться во всех премудростях SEO, предлагаю посетить мои курсы — SEO обучение, которые я провожу индивидуально, в режиме онлайн по скайпу.

Для тех, у кого нет времени проходить обучение и самостоятельно заниматься продвижением своих интернет-магазинов, предлагаю и в этом вопросе помощь. Я могу взять ваш сайт на SEO продвижение и за несколько месяцев вывести его в ТОП10 Google и Яндекс.

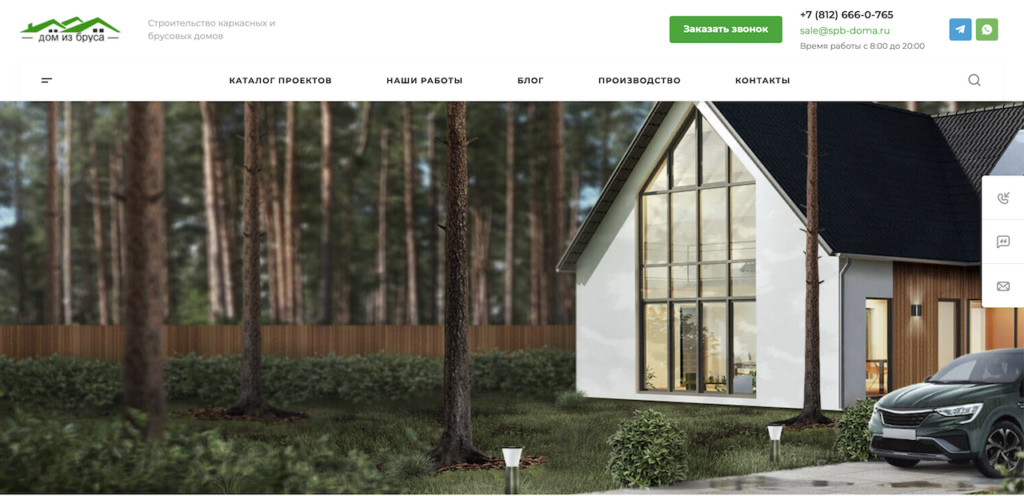

Для того чтобы убедиться в моей экспертности, предлагаю ознакомиться с моими последними SEO кейсами и только после этого заказать у меня SEO продвижение. Ниже на видео один из примеров успешного продвижения строительного сайта в Санкт-Петербурге.

Бесплатный аудит сайта

Бесплатный аудит сайта

Старт

Старт  Стандарт

Стандарт  Премиум

Премиум